헵 학습은 인공지능 및 신경 과학에서 중요한 학습 원리로, 인간의 뇌에서 시냅스가 강화되는 과정을 모방한 학습 방식이다. 헵 학습의 핵심은 다음과 같다.

헵 학습 (Hebbian Learning)

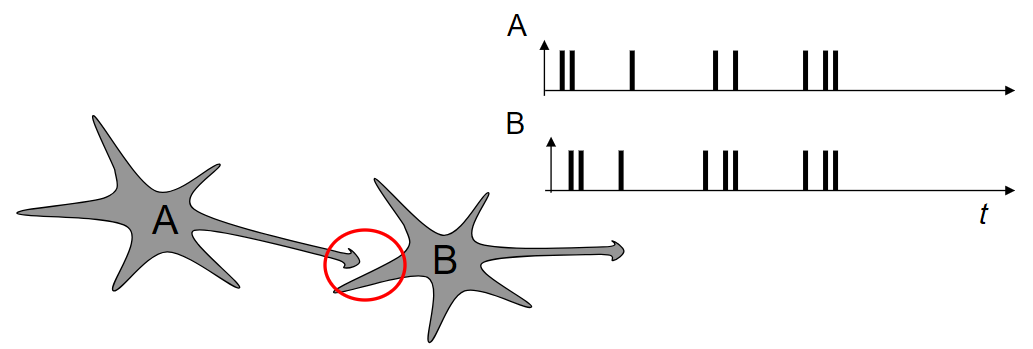

- 기본 원리: 헵 학습의 원리는 캐나다의 심리학자 도날드 헵(Donald Hebb)이 1949년에 제안한 것으로, "함께 발화하는 뉴런이 함께 연결된다"는 문장으로 요약할 수 있다. 두 뉴런이 동시에 활성화될 때 그들 사이의 연결이 강화된다는 개념이다. 이 원리를 통해 시냅스의 가중치가 시간이 지남에 따라 변화하고 강화된다.

- 수학적 모델: 헵 학습의 수학적 표현은 간단하게 다음과 같이 나타낼 수 있다.

Δwij=η⋅xi⋅yj

여기서,- Δwij: 뉴런 i에서 j로의 가중치 변화

- η: 학습률 (learning rate)

- xi: 입력 뉴런의 활성화 상태

- yj: 출력 뉴런의 활성화 상태

- 응용 분야:

- 패턴 인식: 헵 학습은 패턴을 학습하고 인식하는 데 효과적이다. 특히, 자율적인 학습이 필요한 상황에서 사용될 수 있다.

- 기억 및 연상 학습: 생물학적 뉴런과 유사하게, 헵 학습은 기억 형성과 연상 학습을 모방하는 데 사용할 수 있다.

- 비지도 학습: 헵 학습은 외부의 명시적인 지도 신호 없이도 학습이 가능하여, 비지도 학습 문제에 적합하다.

- 제한점:

- 과도한 강화: 동시에 자주 활성화되는 뉴런 간의 연결이 과도하게 강화될 수 있어 학습이 왜곡될 가능성이 있다.

- 경쟁적 억제 메커니즘 부족: 모든 연결이 무차별적으로 강화되기 때문에, 불필요한 연결이 형성될 수 있으며, 이를 억제하는 추가적인 메커니즘이 필요할 수 있다.

헵 학습은 생물학적 학습 메커니즘을 모방하는 대표적인 방식으로, 인간의 뇌가 정보를 학습하고 기억하는 원리를 신경망 모델에 적용하려는 노력의 일환이다.

'컴퓨터공학 > 일반' 카테고리의 다른 글

| Pretraining with Random Noise for Fast and RobustLearning without Weight Transport (0) | 2024.10.24 |

|---|---|

| 인공지능 구현을 위해 기본적인 질문들 (0) | 2024.09.03 |

| 인공지능과 컴퓨터 공학 (0) | 2024.08.04 |